技术

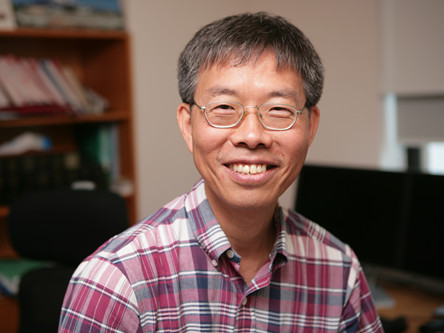

宋謌平博士:微软亚洲研究院首席研究员

里克•雷斯特在天津"二十一世纪的计算"研讨会上的演讲

里克•雷斯特现场演示实时语音翻译技术

让电脑能听会说

智能语音技术的应用日益普及,现在电脑已经可以进行实时语音翻译。机器到底是如何学会"听懂"一个人说的话,并翻译成另一种语言说出来的呢?《科学世界》专访了微软亚洲研究院首席研究员宋謌平博士,请他为我们介绍其中的奥妙。

说话是我们人类最自然、最方便的交流方式。过去,会说话的机器人还只是出现在科幻作品中,但近年来这种技术已逐渐进入我们的生活,你或许已经使用过智能手机上的语音助手,或在开车时用过语音导航。前不久,微软推出了Skype Translator中文预览版,可以实现中英文之间的实时语音翻译,也就是将一个人说的话用对方的语言说出来,让两个只会说各自母语的人可以直接交谈。那么,电脑是如何学会听懂对话内容并翻译成另一种语言说出来的?

智能语音翻译包括3个环节

科学世界:您是什么时候开始研究语音的?

宋謌平:我个人做语音的研究工作已经超过30年。我是从念研究生的时候就开始做,后来加入美国贝尔实验室,工作了20年,然后在日本工作了两年,2004年加入微软亚洲研究院,到现在已经超过10年了。在整个过程中,我基本上做的都是语音的研究,包括说话人识别、语音合成、语音编码、抗噪、增强等。

微软研究院的创始人里克·雷斯特(Rick Rashid)首次提出了微软亚洲研究院要做一个从语音到语音翻译的项目,把以前看似不可能的事变为可能。这个翻译系统做了许多年,我是最早参与这个计划的人之一,这个项目主要由微软的雷蒙德和北京两个研究院负责。

科学世界:实时语音翻译技术包括哪些内容?

宋謌平:语音到语音的翻译系统,基本上可以分成三个模块:语音识别、机器翻译和语音合成。甲跟乙说话,我们要做一个甲说的语言的语音识别,把它听出来,然后把语音变成一串词组,中文的话就是汉字;有了文字以后,第二步是机器翻译,就是把甲说的文字翻译成乙可以理解的语言文字;最后,有了文字以后,还要把它说出来。从乙到甲的话,次序都要反过来。这两个沟通方向,可以说可逆,也可以说不可逆。因为两种语言,它的结构、词汇、发音都很不一样,不同方向上很可能有不同的困难。这三个模块,我们的语音组负责语音识别和语音合成这两部分,机器翻译由自然语言计算组负责。

有人说为什么要那么复杂,大家都用键盘打字不就可以了?但是现在很多终端上的键盘和屏幕都很小,打字不好打,阅读显示的文字也比较费力。另外,许多情况下打字没有说话快。其实只要能够说得清晰、听得懂,语音是一种很好的人机交互界面。

我们当初做语音翻译,听起来就是一个梦想。做了几年之后,2012年10月,在天津召开的"二十一世纪的计算"学术研讨会上,我们做了一个现场展示,就是里克·雷斯特在台上用英文演讲,同时机器识别、翻译,并用语音合成播放出来。

科学世界:那是英文和中文之间的翻译?

宋謌平:对。语音识别技术把里克·雷斯特说的英语识别出来,在大屏幕上显示出英文。大概最多有1秒钟的迟滞,这就是语音识别的过程。认出英文以后,机器翻译成中文。翻译过程中有些因为中英文表达语序不同,所以还要重组后再做翻译。最后是语音合成器把文字变成语音。我们用里克·雷斯特说英文的语料,训练了一个说中文的系统,而且语音听起来像他本人。

科学世界:那么现在这方面有什么实际的应用?

宋謌平:现在通过Skype Translator,我们把它产品化、服务化。这个基本上包括了刚才讲的整个语音识别、机器翻译,还有语音合成的过程。现在我们有Windows Phone、Skype等平台来实现人与人之间的沟通。Skype Translator是目前一个产品化的先锋,我们希望通过它,使说不同语言的人之间可以沟通。另外,有可能实现人和机器之间的沟通。

附件: